最近在公司摸鱼鼓捣了一下怎么在本地部署大模型

使用开源项目 Ollama 还是非常简单的

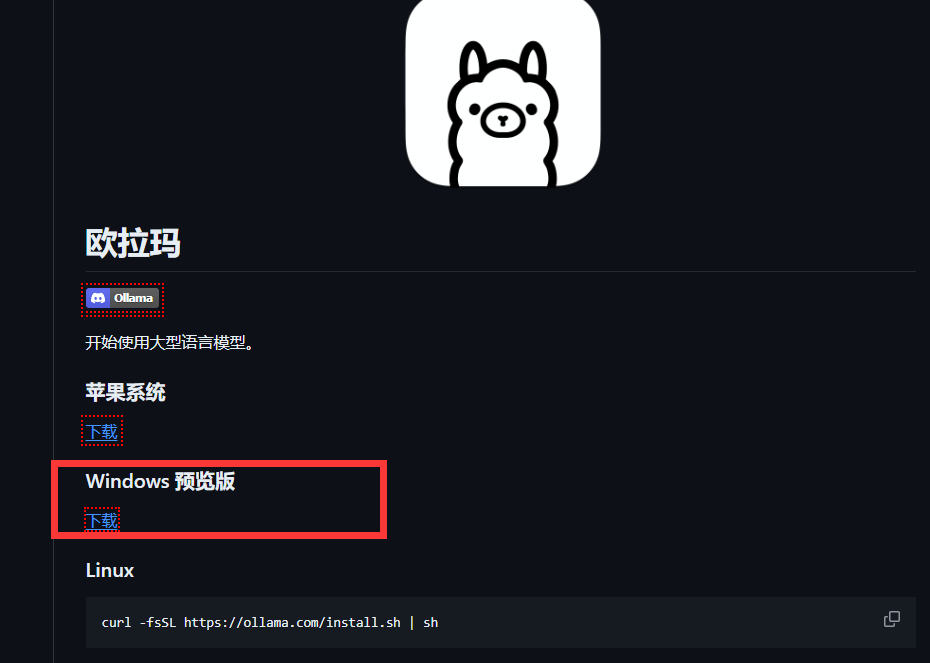

直接在 GitHub 项目发布页下载安装就可以了

我是用的 windows,所以下载的 windows 版本

下载之后无脑下一步,就可以了

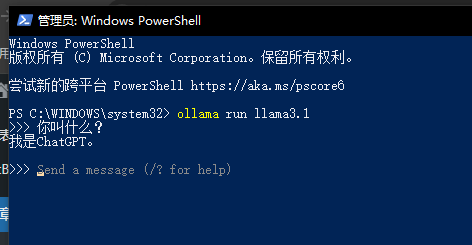

接下来打开 powershell 运行想要部署的大模型

ollama run llama3.1比如 llama3.1,第一次运行会从官网上下载大模型需要一些时间,也可以自己下好了运行

接下来就可以在 powershell 里面直接和大模型对话了

但是这个交互还是稍微丑了点

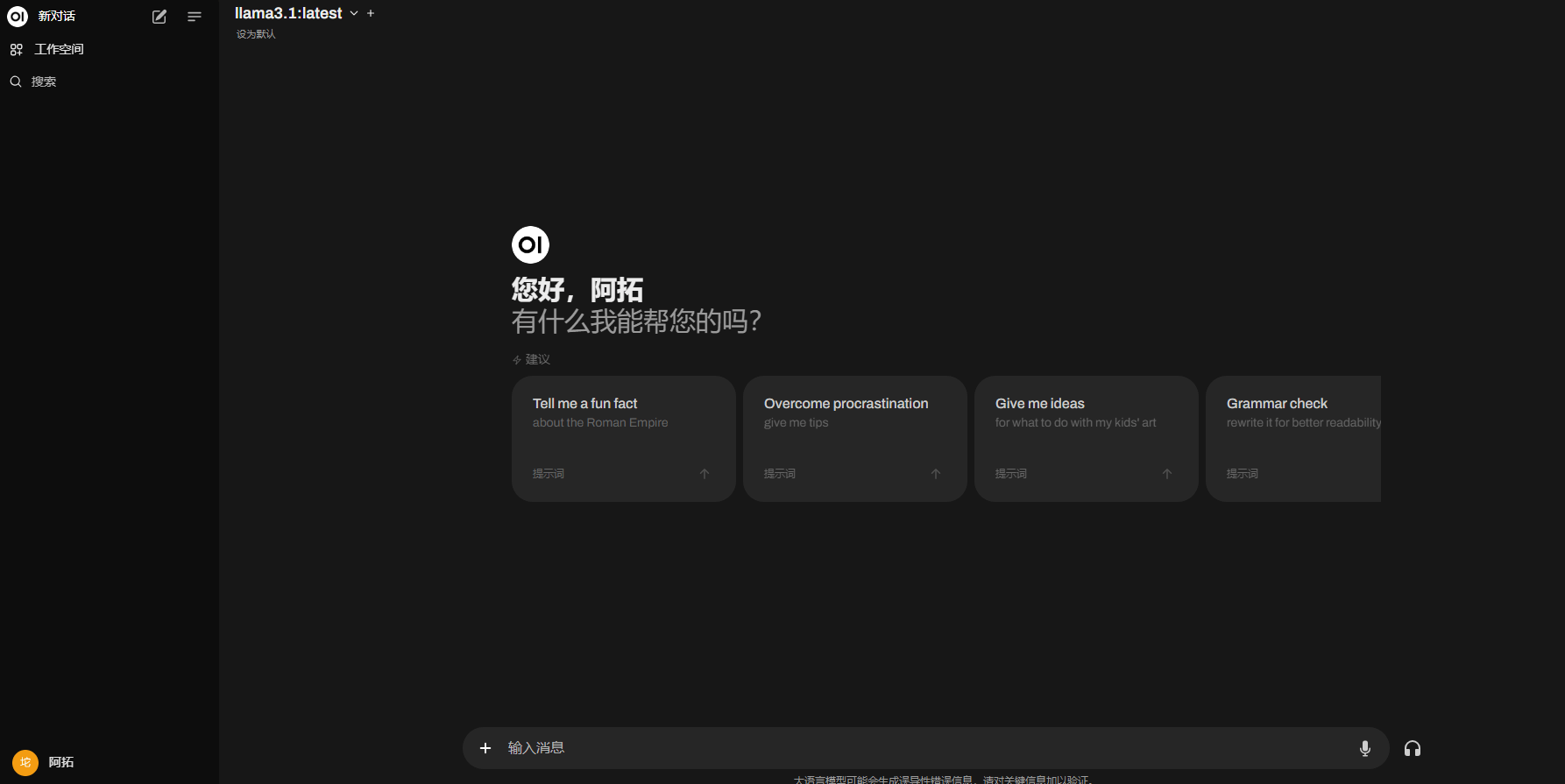

所以还需要搭配 WebUI

我试了两个

一个是 Ollama 推荐的 open-webui

这个 UI、功能都还蛮好的

具体搭建流程参考官方文档

有空的话下次写一下

这个就是依托 Ollama 提供的 http://localhost:11434 接口调用本地大模型

也可以直接对外提供服务

可以进行简单的用户管理

还可以语音交互,还可以接入绘画大模型实现文生图

另外还在抖音看到一个国产的 FastGPT

这个主要是知识库功能好用,但是搭建起来麻烦多了

而且主要是使用 OpenAI 的

功能也有一些阉割

本地部署仅用来学习可以

想要直接拿来用是不行滴

主推的是提供的在线使用服务

但是自己在本地搞着玩也还不错

另外还有一些 WebUI 没有去试

反正都差不多的东西

总结

Ollama 真滴牛逼

一键本地部署大模型太强了

什么都不用管了

另外测试了一下

Llama 3.1 8B 性能真可以

谷歌的 Gemma 2 9B 意外的也很强